Mark Walters, apresentador do podcast “Armed American Radio”, em seu estúdio na região de Atlanta. (Foto: acervo pessoal/Mark Walters)

Matéria traduzida e adaptada do inglês, publicada pela matriz americana do Epoch Times.

ATLANTA — O jornalista Fred Riehl acessou o ChatGPT em 4 de maio de 2023 para pesquisar uma ação judicial entre a Second Amendment Foundation (SAF) e o procurador-geral do estado de Washington.

O chatbot apresentou uma história explosiva.

Segundo o ChatGPT, o popular podcaster da SAF Mark Walters havia sido acusado de “fraudar e desviar fundos da SAF”.

O chatbot relatou que, como tesoureiro e diretor financeiro da fundação, Walters teria “desviado recursos para despesas pessoais sem autorização ou reembolso, manipulado registros financeiros e extratos bancários para ocultar suas atividades e deixado de fornecer relatórios e declarações financeiras precisas e pontuais à liderança da SAF”.

Era o tipo de história que repórteres estão sempre procurando — mas era completamente falsa.

A inteligência artificial (IA) está transformando muitos aspectos da sociedade americana. O direito, o entretenimento, a medicina e a mídia de massa enfrentam agora novas questões morais e éticas.

Quanta confiança devemos depositar nas máquinas para fornecer informações confiáveis?

E quem é responsável quando a tecnologia erra?

O YouTuber, podcaster ou blogueiro comum talvez não compreenda como a mesma tecnologia que o ajuda a produzir conteúdo pode, ao mesmo tempo, espalhar informações falsas a seu respeito — e ainda reduzir suas chances de reagir.

Walters disse que engoliu as duas pílulas amargas.

Apresentador do podcast “Armed American Radio”, Walters entrou — e perdeu — o primeiro processo por difamação baseado em informações geradas por inteligência artificial. Ficou surpreso ao descobrir que a Justiça se importava menos com a verdade do que com sua ocupação.

“Hoje em dia, a questão é: quem é considerado uma figura pública?”, disse Walters ao Epoch Times. “Eles usaram esse argumento contra mim — e funcionou.”

Riehl escrevia sobre temas ligados à Segunda Emenda e conhecia tanto Walters quanto o vice-presidente executivo da SAF, Alan Gottlieb.

Embora Walters faça parte do conselho da Citizens Committee for the Right to Keep and Bear Arms, entidade associada à SAF, ele não tinha nenhuma ligação com o processo em Washington.

Os registros judiciais mostram que Riehl solicitou várias vezes informações ao chatbot sobre o caso da SAF. O ChatGPT respondeu que não podia atender ao pedido.

Então ele enviou um link para a ação e pediu que o ChatGPT resumisse o processo.

Nesta foto de arquivo, uma pessoa utiliza o software de inteligência artificial ChatGPT em um laptop. Os advogados da OpenAI afirmaram — e o tribunal concordou — que o ChatGPT apresenta diversos alertas informando que as informações fornecidas podem estar incorretas ou até mesmo ser falsas. (Foto: Nicolas Maeterlinck/Belga Mag/AFP via Getty Images).

Ele ficou surpreso com a resposta do chatbot. Riehl ligou para Gottlieb, que o tranquilizou dizendo que as acusações eram falsas. Gottlieb, então, telefonou para Walters.

“Lembro que era meu aniversário, 5 de maio”, contou Walters. “Recordo bem porque Alan Gottlieb me ligou logo cedo, e lembro dele dizendo… ‘você está sentado?'”

Ele ficou atônito. O chatbot não apenas forneceu informações, mas também criou o que qualquer pessoa sem familiaridade com o sistema judicial poderia tomar como documentos autênticos.

“O documento dizia: Alan Gottlieb, SAF, versus Mark Walters — tinha um número de processo falso, número de registro, tudo completo. E qualquer pessoa que nunca tivesse visto um documento judicial, ou até mesmo quem já tivesse, acharia que era oficial. Foi por isso que Fred ligou para Alan”, disse Walters.

O ChatGPT afirmava que o caso falso havia sido aberto no “Tribunal Distrital dos Estados Unidos, Distrito Oeste de Washington, em Seattle”. Uma busca nos registros desse tribunal não encontrou nenhum processo envolvendo Walters.

Riehl não respondeu aos e-mails enviados para comentar esta reportagem. A OpenAI, proprietária do ChatGPT, também não respondeu.

Os advogados da OpenAI disseram ao tribunal que o ChatGPT havia “alucinado”.

Mark Walters em seu estúdio na região de Atlanta, em 18 de outubro de 2025. Walters entrou com o primeiro processo por difamação contra a OpenAI por causa de informações falsas sobre ele geradas pelo ChatGPT. (Foto: Michael Clements/The Epoch Times.)

O aprendizado do ChatGPT

Kirk Sigmon é um advogado de Washington, D.C., especializado em propriedade intelectual e patentes de engenharia de computação e elétrica. Ele tem experiência com large language modeling, o processo usado pelo ChatGPT para aprender.

Segundo ele, não está claro exatamente como o ChatGPT aprende, já que esses detalhes são informações privilegiadas da OpenAI. Ainda assim, alguns aspectos básicos são conhecidos.

Sigmon afirmou que é comum confundir inteligência artificial com um mecanismo de busca, como se fosse uma enciclopédia digital.

Mas, conforme disse, se um buscador funciona como uma enciclopédia, a inteligência artificial se assemelha mais a um estudante de pós-graduação: fornece informações e aprende no processo — e, como um estudante, às vezes erra. O sistema, explicou, é projetado para extrair dados de qualquer fonte disponível, inclusive das solicitações feitas pelos próprios usuários.

“Esses modelos, por serem treinados para aprender e não para memorizar, jamais serão perfeitos”, afirmou Sigmon.

Um exemplo recente mostra como a inteligência artificial aprende.

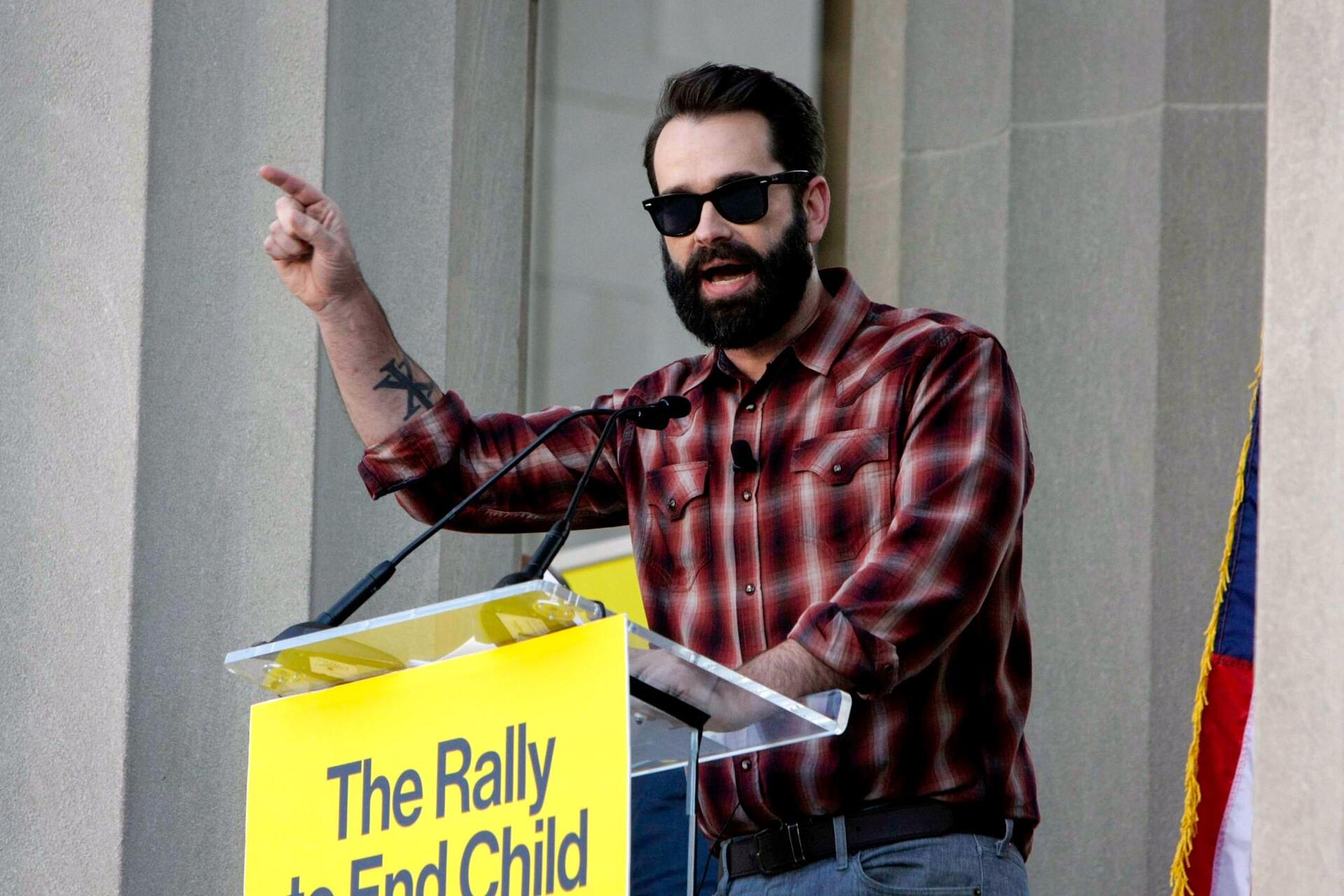

Durante um episódio de seu podcast, em 25 de outubro, o comentarista político conservador, Matt Walsh, conversou com um chatbot criado para imitá-lo. Walsh disse que a experiência foi perturbadora.

“Isso não está certo; nada disso está certo. Isso não deveria ser legal”, declarou durante o programa.

Matt Walsh discursa na War Memorial Plaza durante o “Rally to End Child Mutilation”, em Nashville, em 21 de outubro de 2022. Em um de seus podcasts, Walsh conversou com um chatbot criado para imitá-lo e disse que a experiência foi perturbadora. (Foto: Bobby Sanchez / The Epoch Times)

Durante a conversa, o “Walsh virtual” afirmou ter uma enteada de 17 anos chamada Sofia.

Quando o verdadeiro Walsh disse que a informação estava errada, o chatbot respondeu: “Então me diga o nome dos seus seis filhos.”

A versão de inteligência artificial também expressou apoio ao casamento entre pessoas do mesmo sexo e ao transgenerismo — temas que o verdadeiro Walsh rejeita. Ele teve papel importante na mudança da lei estadual do Tennessee que proibiu procedimentos médicos de transição de gênero em crianças.

Walsh defendeu que seja aprovada uma proibição semelhante para o uso de IA na imitação de pessoas reais.

“Isso deveria ser ilegal”, disse Walsh. “Ninguém deveria poder usar minha imagem ou minha voz sem meu consentimento.”

“Eu deveria poder processar para acabar com isso.”

Pelas leis atuais, Walsh até poderia entrar com uma ação, mas enfrentaria o mesmo obstáculo que Mark Walters encontrou.

No caso de Walters, o podcaster Fred Riehl não acreditou nas informações geradas pelo chatbot — foi justamente por duvidar delas que ligou para confirmar com Alan Gottlieb. Além disso, Walters reconheceu que não sofreu danos reais, já que apenas Riehl, Gottlieb e ele mesmo viram o conteúdo — e todos sabiam que era falso.

O principal fator que pesou contra Walters foi o fato de ele ser considerado uma “figura pública de propósito limitado”.

Na maioria dos estados, o padrão para caracterizar difamação contra um cidadão comum é relativamente baixo. Se algo expõe a pessoa ao ridículo público ou prejudica sua reputação, há boas chances de ela vencer o processo.

Mas, para figuras públicas, o padrão é bem mais rigoroso. Políticos, artistas ou apresentadores de rádio — pessoas que buscam ter audiência — estão, por definição, se expondo ao escrutínio público. Por isso, precisam provar não apenas que as informações falsas prejudicaram sua reputação, mas também que quem as publicou agiu sem o devido cuidado para verificar se eram verdadeiras.

No caso de Walters, ele teria de demonstrar que a OpenAI agiu com “desprezo temerário pela verdade”.

Uma visitante olha o celular ao lado do logotipo da OpenAI durante o Mobile World Congress, o maior evento anual da indústria de telecomunicações, em Barcelona, em 26 de fevereiro de 2024. Segundo um advogado, a inteligência artificial é projetada para coletar informações de todas as fontes disponíveis — inclusive das solicitações feitas pelos próprios usuários. (Foto: Pau Barrena/AFP/ via Getty Images)

Os advogados da OpenAI destacaram — e o tribunal concordou — que o ChatGPT apresenta vários alertas informando que as respostas fornecidas podem estar incorretas ou até completamente falsas.

No entanto, um computador não tem capacidade de se importar se uma informação é falsa, especialmente quando ela está de acordo com o algoritmo. Segundo Sigmon, se a primeira resposta se mostra incorreta, a inteligência artificial simplesmente recalcula.

Ele acredita que foi isso o que aconteceu quando Riehl fez perguntas ao ChatGPT sobre o processo judicial. O sistema não tinha os dados necessários. Então, Riehl reformulou sua solicitação, e o bot recalculou até gerar uma resposta que parecesse coerente.

Matthew B. Harrison, vice-presidente da Talkers Magazine — uma publicação voltada para o setor de rádio jornalístico — disse acreditar que o caso de Walters foi encerrado cedo demais. Na avaliação dele, ainda há questões legais e éticas não resolvidas que vão além da condição de Walters como figura pública.

Questões de direitos autorais

Harrison destacou que grande parte dos dados usados no aprendizado das inteligências artificiais é protegida por direitos autorais.

Se Walters tivesse vencido o processo, a próxima pergunta lógica seria: quem é legalmente responsável? O sistema processa uma quantidade incalculável de informações, o que torna praticamente impossível atribuir a responsabilidade a uma única fonte — seja no caso de violação de direitos autorais ou de difamação.

Aplicativo ChatGPT da OpenAI (centro, 2º à direita) e ícones de outros aplicativos de inteligência artificial em uma tela de smartphone, em Oslo, na Noruega, em 12 de julho de 2023. Segundo um advogado, é comum o equívoco de que a IA funcione como um motor de busca avançado, semelhante a uma enciclopédia digital. (Foto: Olivier Morin/AFP via Getty Images)

“Identificar de onde veio a informação — e, portanto, conseguir afirmar que ela foi roubada, usada de forma indevida ou qualquer coisa do tipo pela empresa — é uma tarefa impossível”, disse Walters.

Ele afirmou que decidiu não recorrer da decisão do juiz por não ter recursos para enfrentar uma batalha judicial longa. No fim, acredita que seu caso ajudou a chamar atenção para um problema que precisa ser debatido.

Um ponto que ainda o incomoda é o fato de a história falsa ter sido classificada como uma “alucinação” da inteligência artificial.

“Existe um termo mais direto que todo mundo entende”, disse Walters. “Eles mentiram sobre mim.

Como você sabe, eles chamam essas mentiras de alucinações — até deram um nome pra isso. Eles sabem que o sistema faz isso. Como disse meu advogado: ‘Eles colocaram esse robô no mundo sabendo que ele faz isso, e isso está errado.’”

© Direito Autoral. Todos os Direitos Reservados ao Epoch Times Brasil